Аудит сайтов — 2016

В данной статье приводятся результаты аудита сайтов, проводившегося на федеральном семинаре «Современные технологии сайтостроения и комплексного интернет-маркетинга для решения бизнес-задач в новых рыночных реалиях», состоявшегося в Москве, 1 декабря 2016 года.

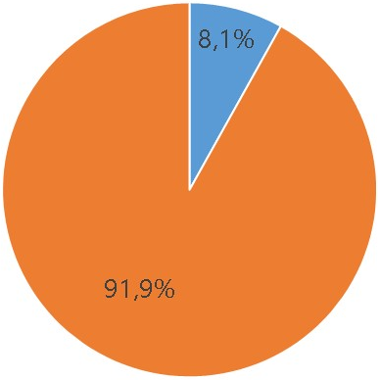

Передача данных по защищенному протоколу (https / http)

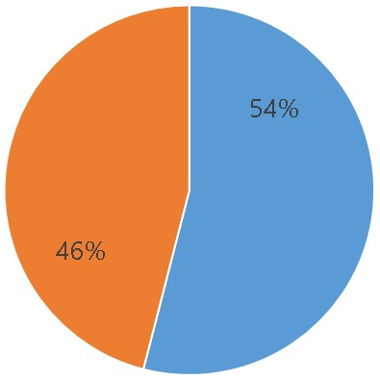

Защита передаваемых данных — важный параметр с точки зрения поисковых систем. Сайты, работающие по безопасному протоколу https, ранжируются поисковыми системами выше, нежели чем сайты, работающие по стандартному http. Более того, уже с 2017 браузеры FireFox и Chrome при попытке перехода на сайт с протоколом http будут выдавать пользователю специальную предупреждающую табличку о небезопасности установленного соединения. Поэтому работа по безопасному протоколу https — обязательное требование, предъявляемое к современным сайтам. Однако статистика говорит, что далеко еще не все сайты перешли на безопасный протокол.

https

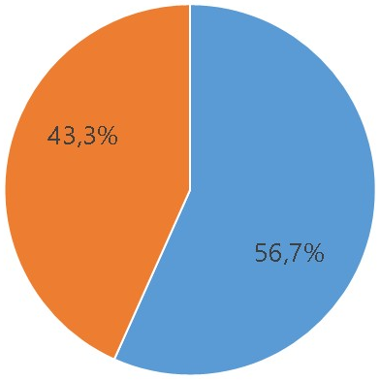

Склейка зеркал (www / без www)

Один пользователь набирает адрес сайта с www, другой — без www, однако этих пользователей объединяет одно: они пользуются поисковыми системами. А с точки зрения поисковых систем сайт без www и сайт c www — это два разных сайта. И чтобы поисковая система считала их единым целым, эти зеркальные адреса требуется склеить. Однако склейку зеркал производят не все владельцы сайтов.

Зеркала не склеены

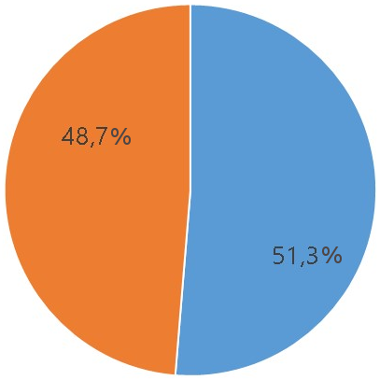

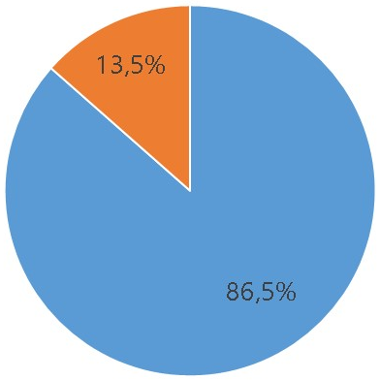

Наличие карты сайта для поисковых роботов

Для хорошей ориентации на местности нужна подробная карта. Для хорошей ориентации робота поисковых систем на сайте ему нужна карта этого сайта. Карта сайта указывает роботам «путь индексации»: какие изменения произошли с добавленными ранее страницами и разделами, появились ли на сайте новые страницы. Конечно, робот может найти всю эту информацию и самостоятельно, но делать он это будет очень и очень долго...

Как видно из статистики, поисковую карту роботам поисковых машин вручает лишь половина владельцев сайтов.

Отсутствует

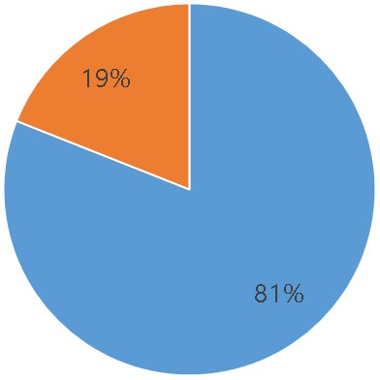

Наличие файла robots.txt для поисковых роботов

У каждого сайта есть своя «личная жизнь»: это и страницы, находящиеся в разработке, и страницы «не для широкого пользования», доступные лишь узкому кругу избранных, и просто информация, индексировать которую нежелательно. И именно с помощью файла robots.txt и даются указания поисковым роботам, какие разделы сайта нужно посещать, а куда заходить попросту нельзя. И о том, что такой файл можно и нужно создавать, знают многие.

Отсутствует

Дублирование страниц со «/» и без «/»

При создании сайта нужно с самого начала определиться, будут ли адреса страниц и разделов заканчиваться на «/„. И потом уже, при контентном наполнении сайта, при создании внутренней перелинковки страниц ставить ссылки на другие страницы сайта либо с наличием “/», либо без него. Иначе поисковый робот подумает, что это две разные страницы. Кстати, для сайтов, проходивших аудит, робот так думает чуть более чем в половине случаев.

Нет редиректа

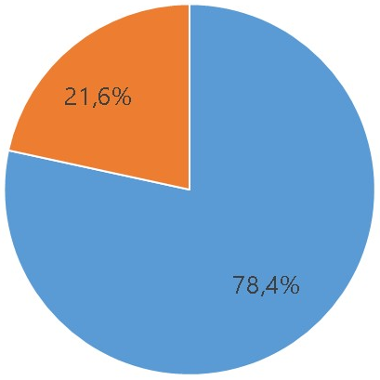

Корректный ответ «404»

Сайт живет, его структура меняется, появляются новые страницы и удаляются ненужные. Однако адрес удаленной страницы может остаться в сети, и возникает вопрос, какой же ответ получит поисковый робот, совершивший переход на уже несуществующую страницу? При грамотной настройке параметров сайта поисковой робот в данной ситуации должен получить корректный ответ 404 (404 страницу), т.е. роботу поисковых систем нужно сказать, что такая страница раньше-то была, но теперь ее не существует, а вот заодно и пару ссылок, перейди по ним. Кстати, такая страница нужна и для людей тоже, она позволит удержать часть посетителей, перешедших на старым ссылкам на удаленные страницы.

И надо заметить, что у большинства аудируемых сайтов такая страница присутствует.

Не работает

Сжатие файлов GZIP

Скорость передачи информации по интернету конечна, и повысить её можно как с помощью усиления канала, так и с помощью уменьшения размера передаваемых файлов. Само собой, владельцам сайтов доступно лишь второе. Наличие функции сжатия файлов GZIP является необходимой для увеличения скорости работы сайта. А скорость сайта, в свою очередь, значительным образом влияет на такой важный показатель как конверсия.

Нет

Отдельной строкой следует привести следующие статистические данные: средняя скорость загрузки сайтов очень медленная, а размер главной страницы в среднем составляет более 2,6 mb. Это достаточно низкие показатели по современным требованиям.

Тем не менее можно сказать, что ситуация на рынке улучшается, всё больше сайтов начинают прислушиваться к требованиям рынка и используют средства, которые становятся уже необходимыми для быстрой и эффективной работы. В 2017-ом году основной акцент будет на HTTPS и мобильном интернете, так что владельцам стоит позаботиться о том, чтобы страницы были сделаны качественно, адаптивно и передавались по защищённому протоколу.

Оставить комментарий